GPT-4.1 偷摸开测?神秘模型登顶编程榜,社区细扒指向 OpenAI,网友:营销鬼才又来了

GPT-4.1 偷摸开测?神秘模型登顶编程榜,社区细扒指向 OpenAI,网友:营销鬼才又来了神秘免费 AI 模型 Quasar Alpha 上线,性能出色引发关注

神秘免费 AI 模型 Quasar Alpha 上线,性能出色引发关注

印度人工智能初创公司 Ziroh Labs ,与该国顶尖技术学院的研究人员合作,设计出一套经济实惠的系统,据称无需依赖英伟达公司等提供的高端计算芯片,即可运行大型 AI 模型。

在 2024 年七月的一篇博客文章中,Meta CEO 马克·扎克伯格表示,“出售访问权限”给 Meta 公开可用的 Llama AI 模型“不是 Meta 的商业模式。”

欧洲初创公司 Pruna AI 一直在研究 AI 模型的压缩算法,该公司的优化框架将于周四开源。Pruna AI 在几个月前完成了 650 万美元的种子轮融资。参与此次初创公司投资的包括 EQT Ventures、Daphni、Motier Ventures 以及 Kima Ventures。

据外媒 TechCrunch 报道,OpenAI 近日在一项新的政策提案中,将 DeepSeek 描述为被官方资助和控制的实体,并呼吁对该机构及类似机构开发的中国 AI 模型实施禁令。OpenAI 在提案中指出:「虽然目前美国在 AI 领域仍保持领先,但 DeepSeek 的出现表明,这一领先优势并不大,且正在缩小。」

半个月前,Anthropic 发布了其迄今为止最聪明的 AI 模型 —— Claude 3.7 Sonnet。

今天,他们自称发布了世界上最好的 OCR API,它能够将复杂的 PDF 文件转换为文本文件,以便 AI 模型处理。现在,所有大模型的输入端格式都是文本,或者规整的、容易识别的文本文件,但这个世界上,还有很多文件是粗糙的,不规整的,难以识别的,它需要依赖强大的 OCR 功能才能转换为文本。

播客录制和编辑平台 Podcastle ,如今也加入了 AI 文本转语音竞赛,发布了其名为 Asyncflow v1.0 的 AI 模型。同时,还将为开发者提供 API,使他们能够直接将文本转语音模型集成到自己的应用中。

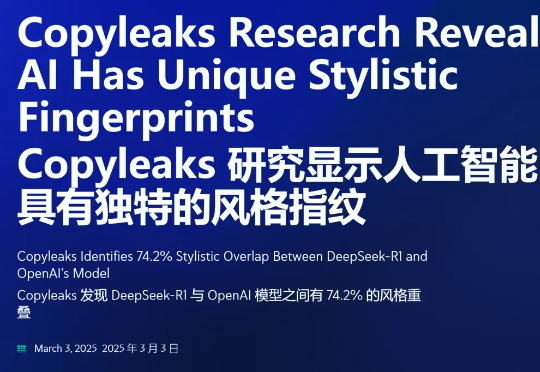

在 DeepSeek 生成的文本中,有 74.2% 的文本在风格上与 OpenAI 模型具有惊人的相似性?这是一项新研究得出的结论。这项研究来自 Copyleaks—— 一个专注于检测文本中的抄袭和 AI 生成内容的平台。

全球生态学家正面临一场「数据海啸」——红外相机陷阱每天产生数百万张野生动物照片,但人工分类需耗时数周。